목차

1. Recursive least squares adaptive filters

1-3. Normal equation Reformulation

1-4.

1-5. Tap-weight vector의 time update

2. RLS algorithm의 convergence analysis

2-2. Mean value에서 RLS 알고리즘의 수렴

2-3. RLS 알고리즘의 mean-square deviation

2-4. RLS 알고리즘의 Ensemble-average learning curve

※ 수식 전개는 계산 용이성을 위해, complex가 아닌 real을 가정하였습니다.

최소제곱(Least Squares)을 재귀적으로 업데이트하는 RLS (Recursive Least-Square) 알고리즘을 정리해봅시다.

1. Recursive least squares adaptive filters

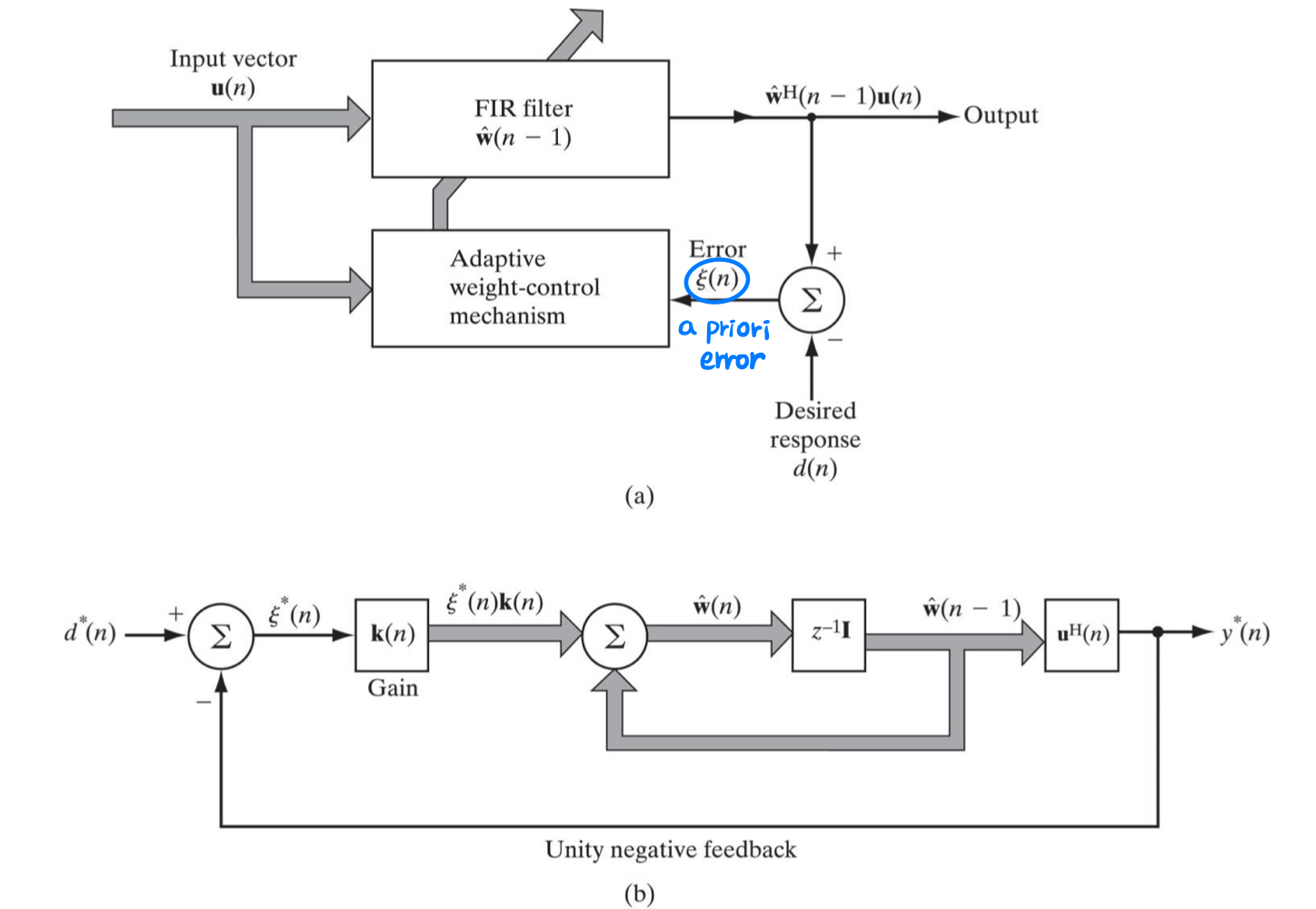

1-1. RLS 알고리즘이란 무엇인가?

RLS 알고리즘은 이전 시간 스텝

RLS 알고리즘은 위 cost function

1-2. Regularization

Least-squares 추정은 ill-posed inverse problem이라는 특성 때문에 아래와 같은 문제를 가집니다.

- 입력 데이터만으로 입력-출력 간 관계(mapping)를 고유(unique)하게 복원하기엔 정보가 부족합니다.

- 입력 데이터에 노이즈가 포함되어있거나 값이 부정확하면 입력-출력 간 관계를 정확하게 파악하기 어려워집니다(uncertainty).

Least-squares 추정을 well-posed problem으로 만들기 위해서는, 사전 정보(prior information)을 cost function에 포함시킬 필요가 있습니다. 다시 말해, 입력 데이터만으로는 불충분하거나 불확실성이 클 수 있기 때문에, 추가적인 제약이나 규제를 cost function에 반영하여 문제를 명확하게 해결할 수 있도록 해야 합니다.

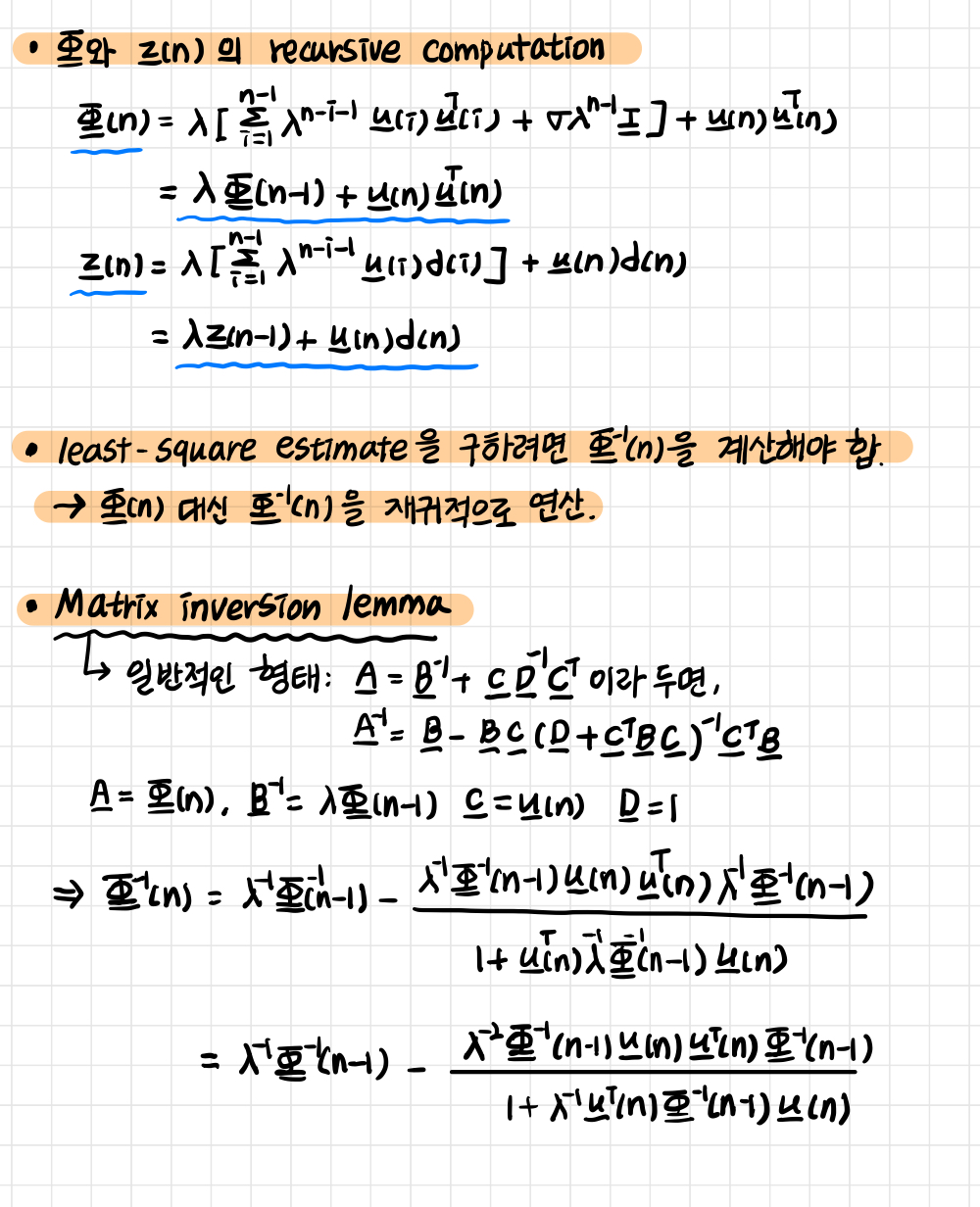

1-3. Normal equation Reformulation

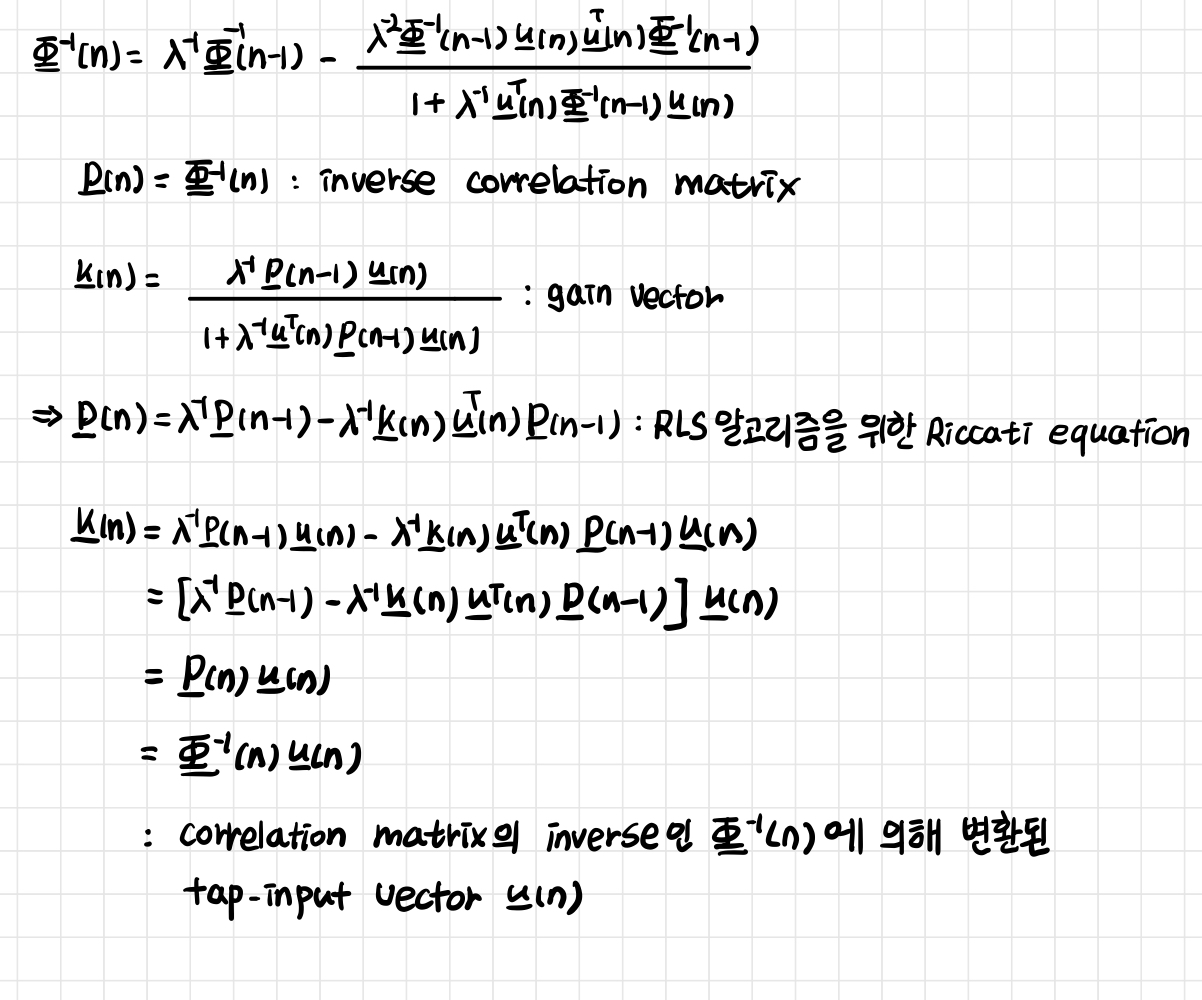

1-4.

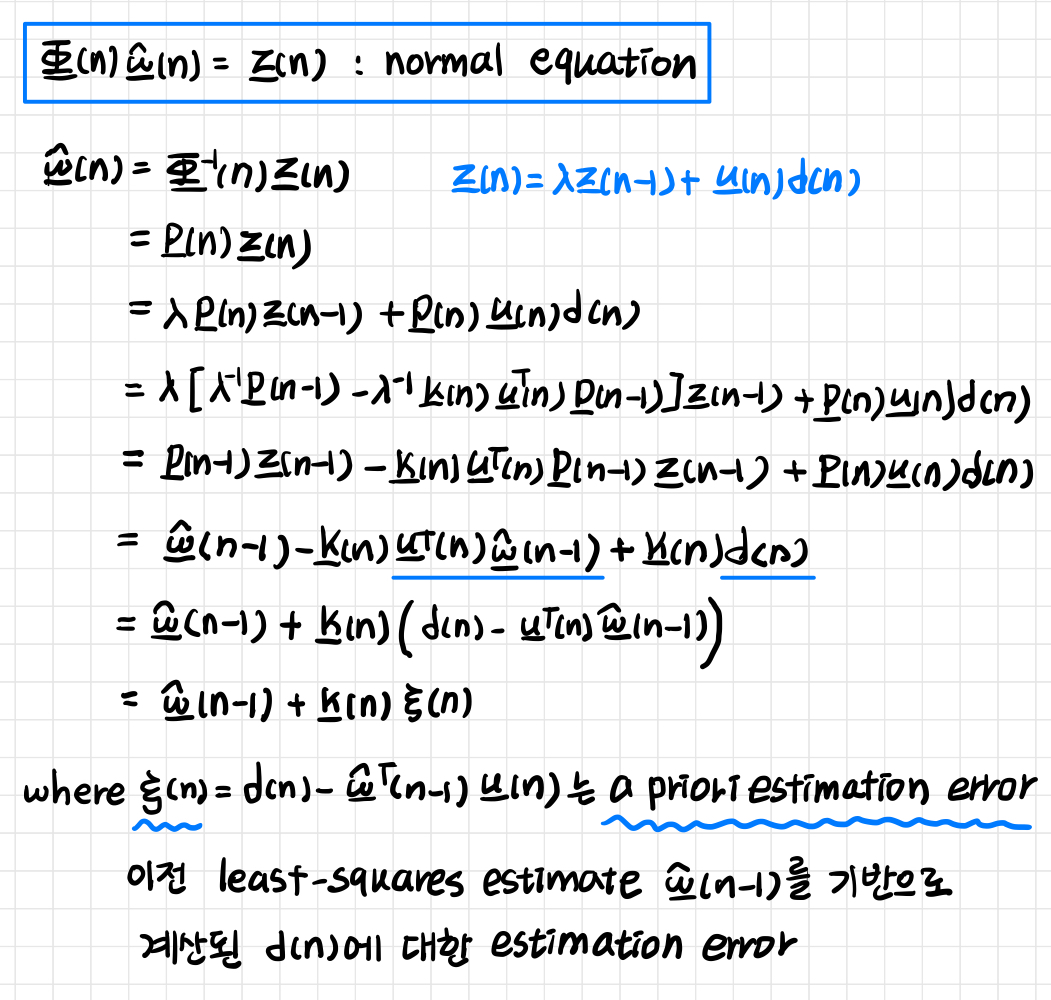

1-5. Tap-weight vector의 time update

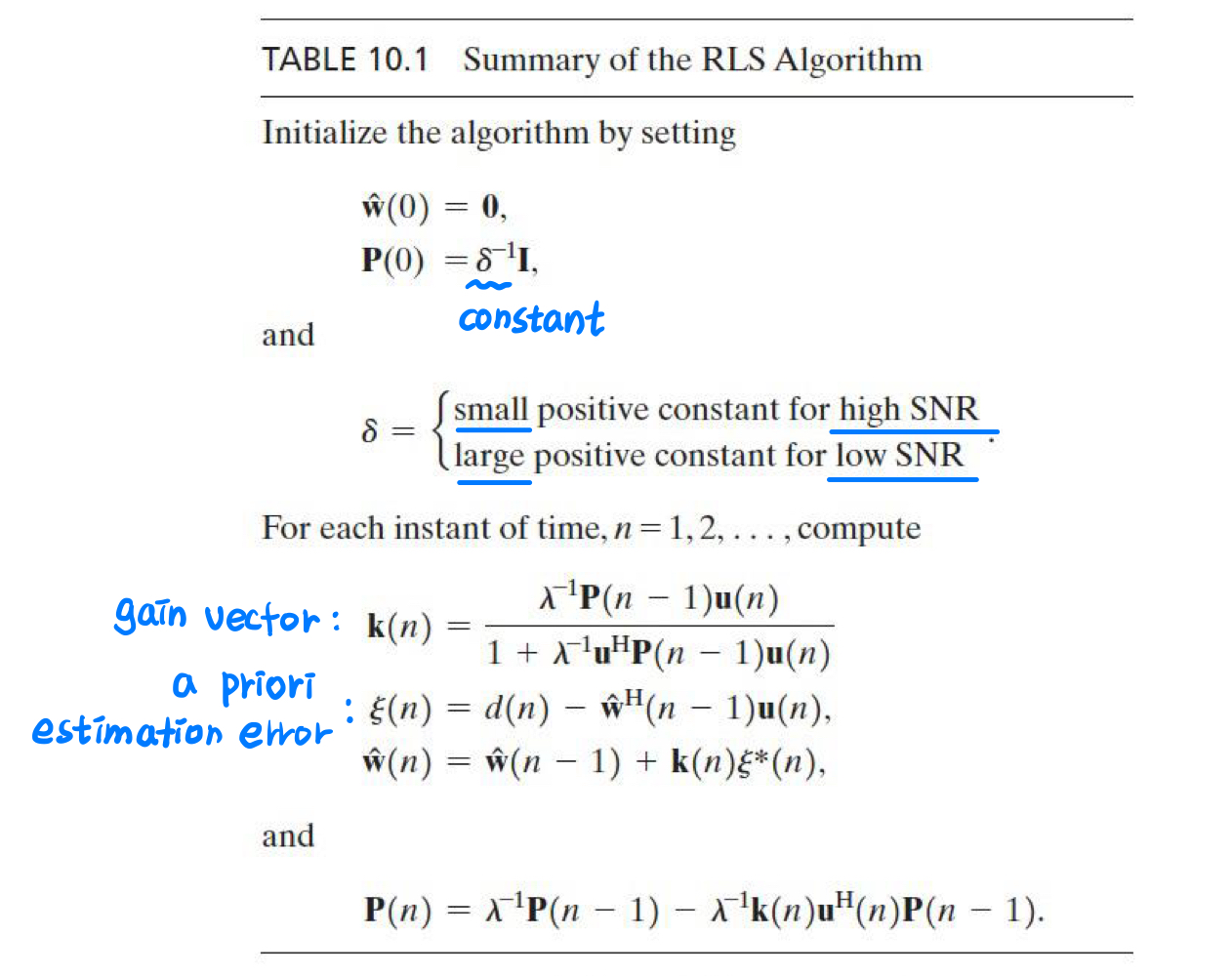

1-6. RLS 알고리즘 한 눈에 보기

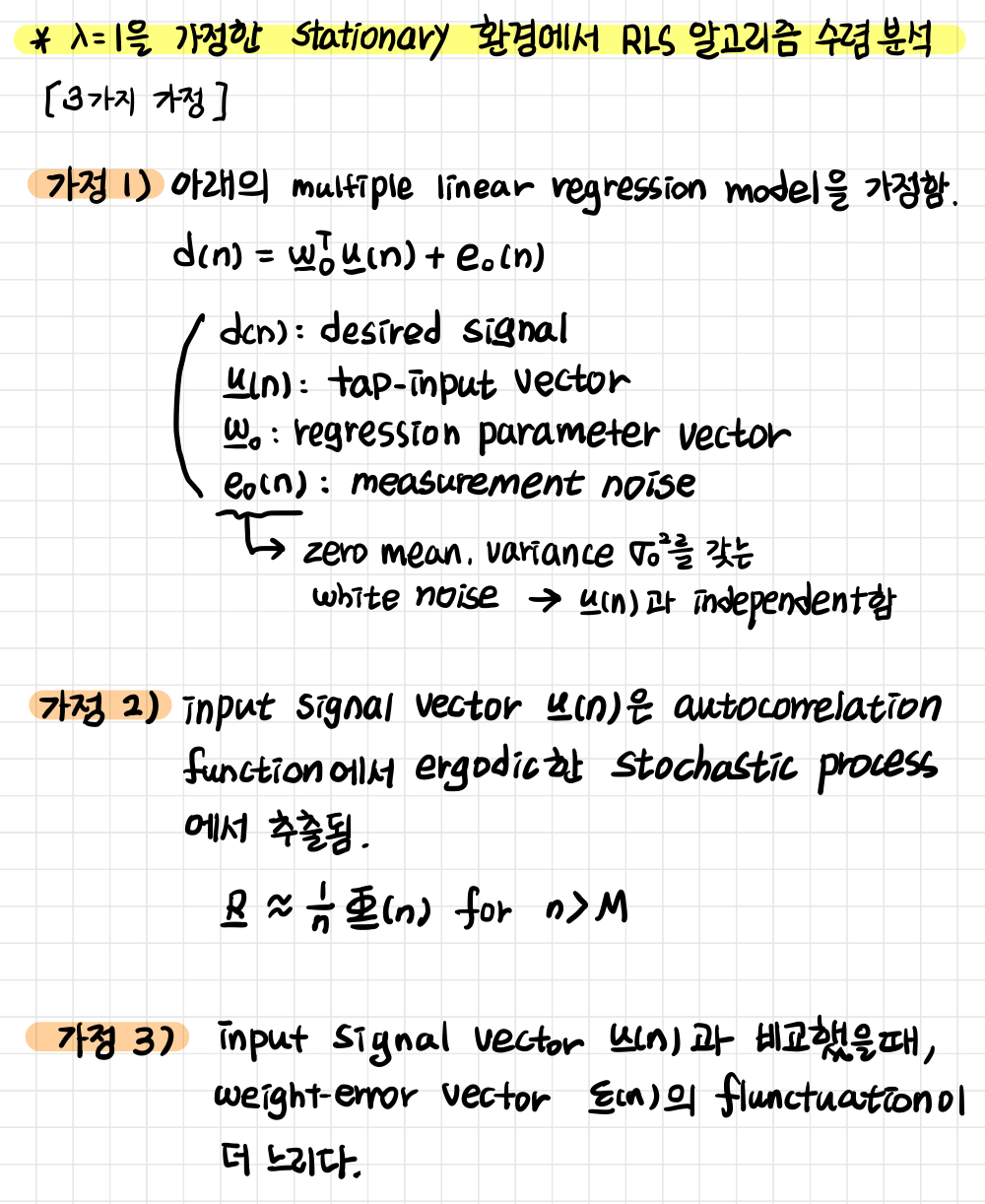

2. RLS algorithm의 convergence analysis

2-1. Assumption

[용어정리]

- stochastic process: 확률적인 규칙에 따라 데이터가 생성됨

- ergodic: 시간에 따른 평균이 확률적인 평균과 같음, 샘플 데이터가 전체 확률 분포를 잘 대표함

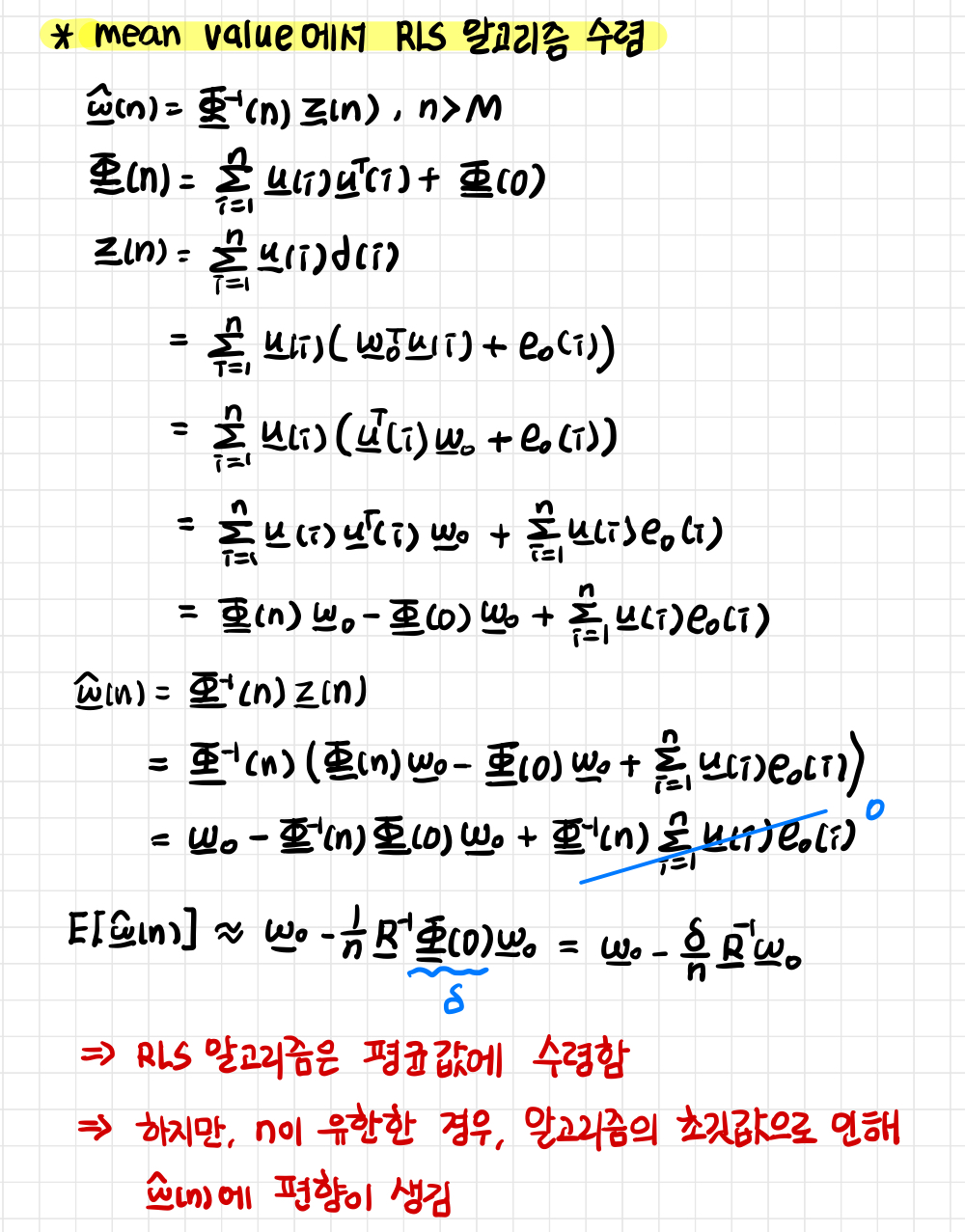

2-2. Mean value에서 RLS 알고리즘의 수렴

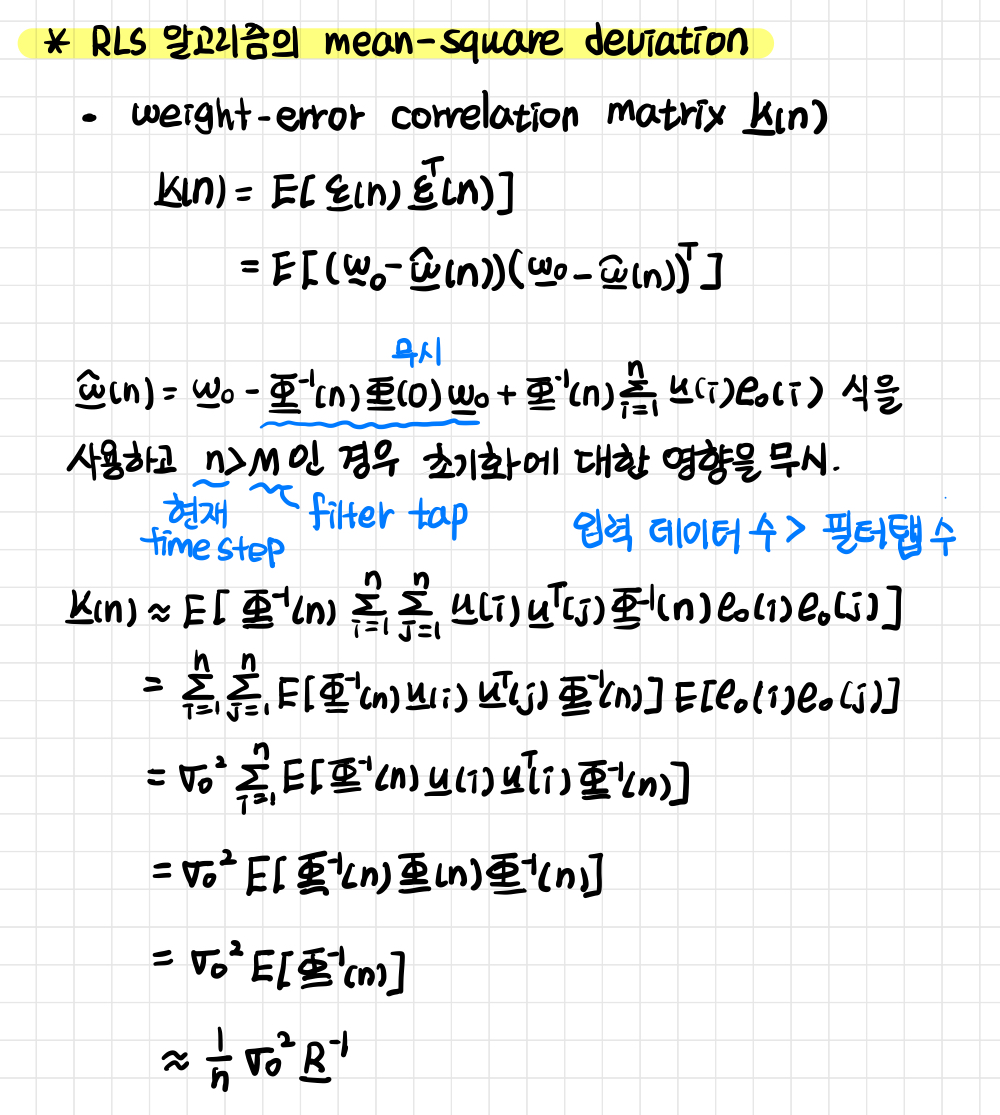

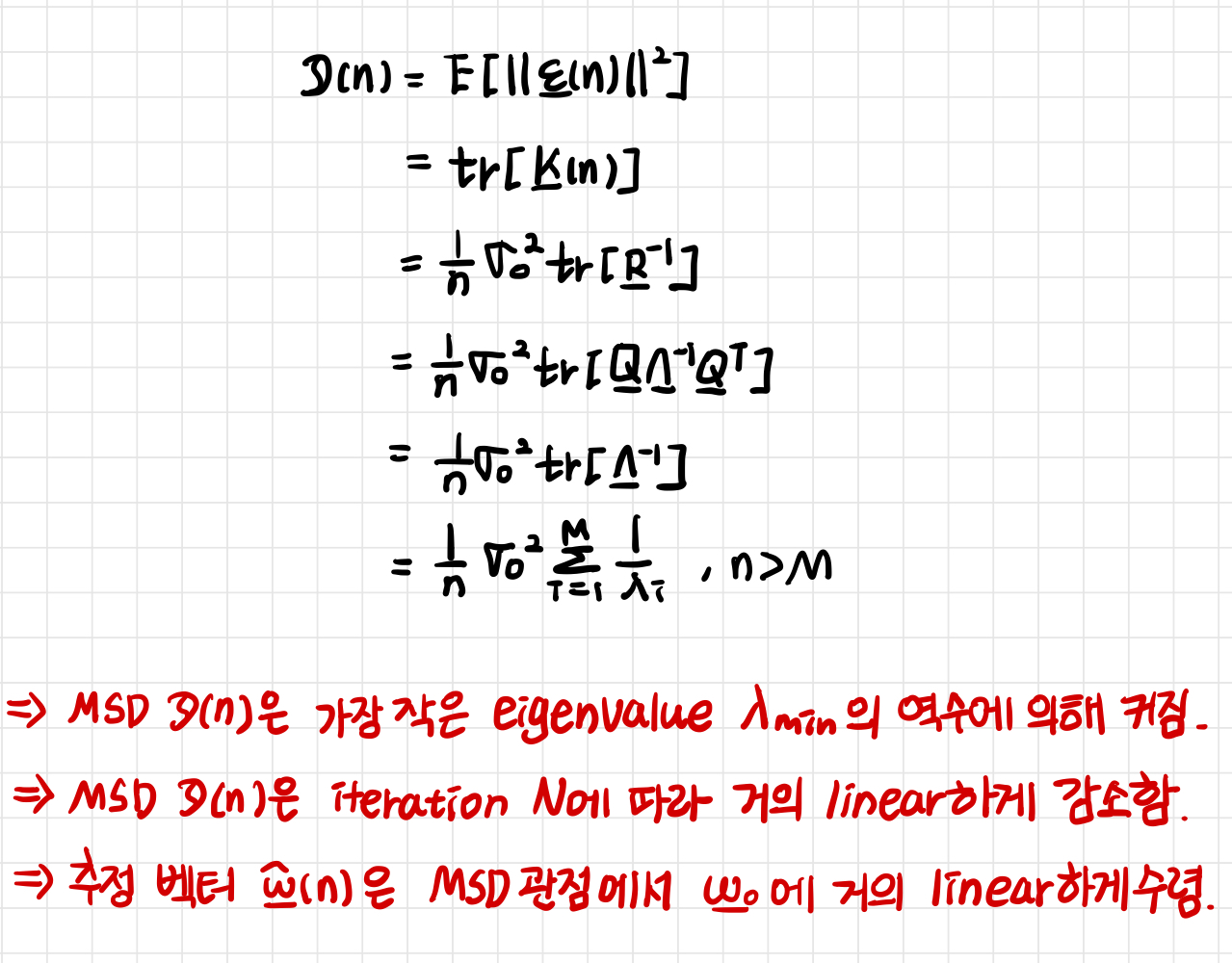

2-3. RLS 알고리즘의 mean-square deviation

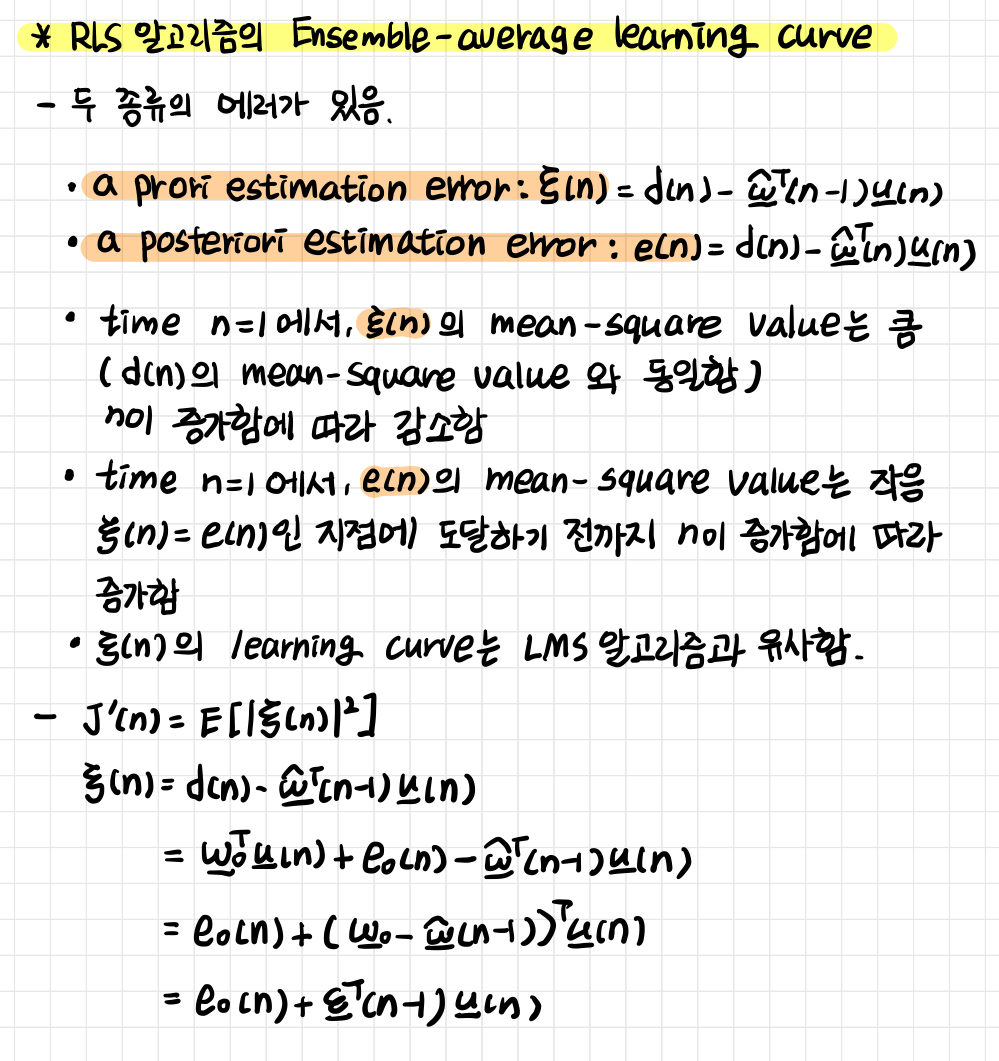

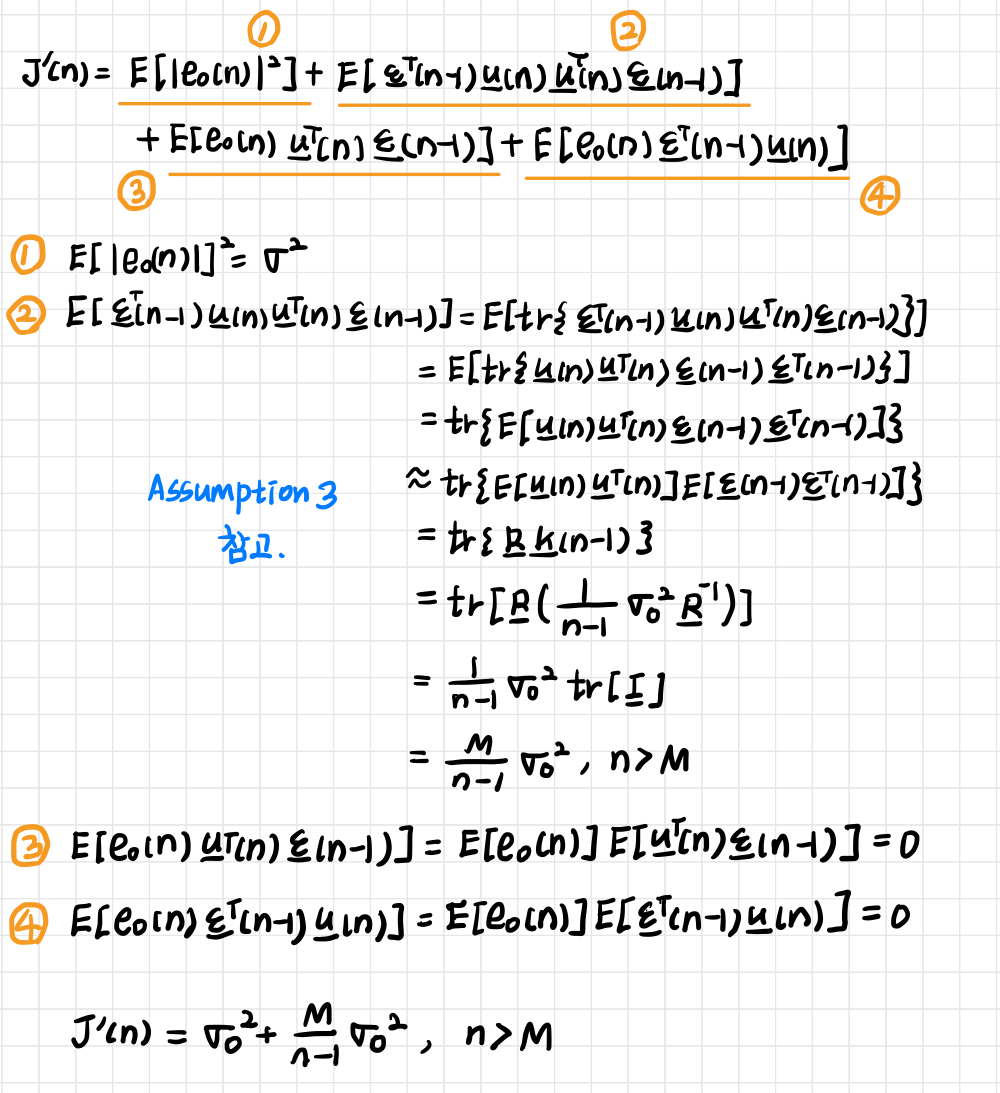

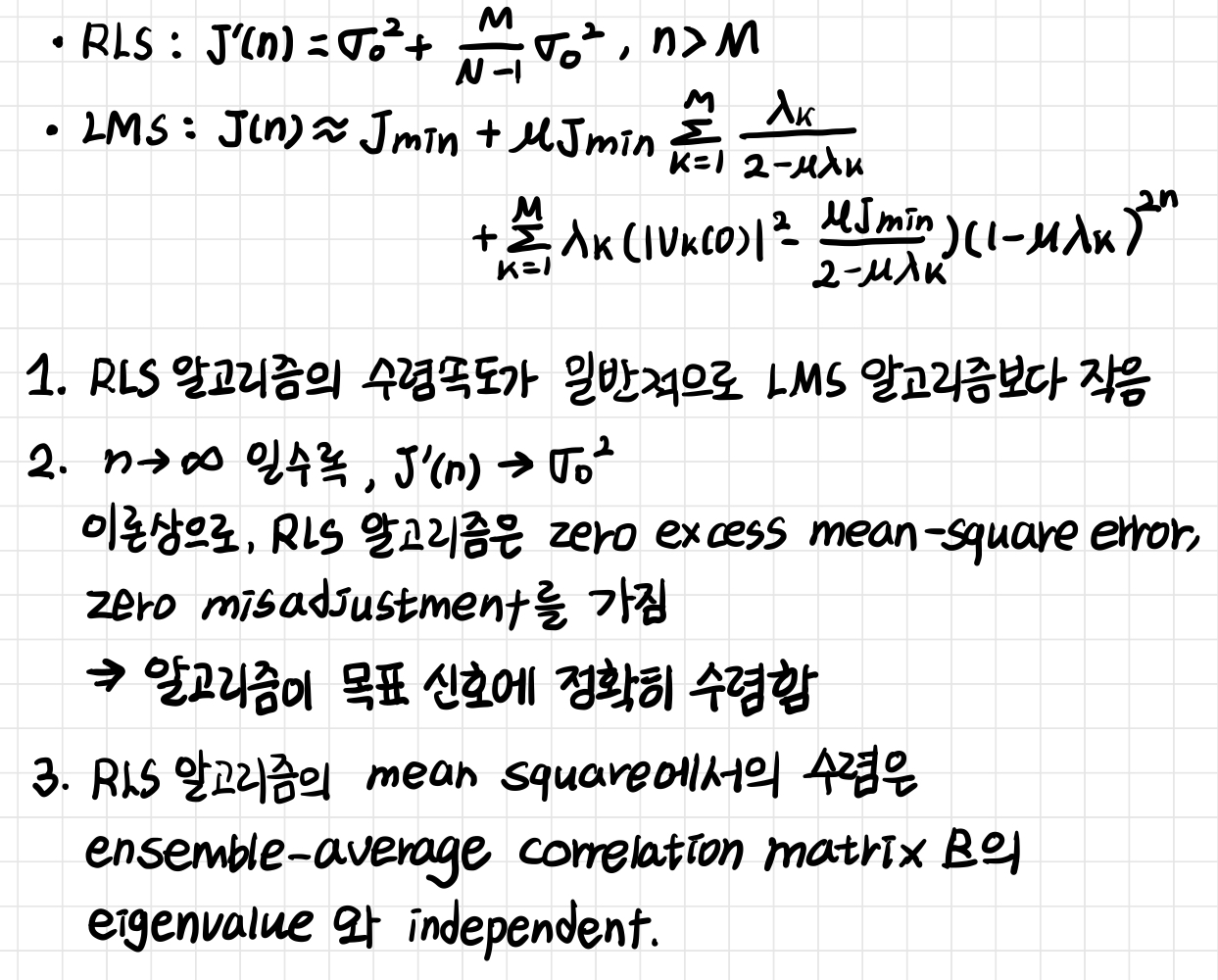

2-4. RLS 알고리즘의 Ensemble-average learning curve

GIST 신종원 교수님 '적응신호처리' 수업 자료를 바탕으로 쓴 글입니다.

'연구 노트 > 적응신호처리' 카테고리의 다른 글

| Kalman Filter 정리 (1) | 2024.12.15 |

|---|---|

| 최소제곱법 (Least Square Method) 정리 (0) | 2024.12.12 |

| Frequency-Domain & Subband Adaptive filter 정리 (1) | 2024.10.28 |

| Fast block LMS 알고리즘 이해하기 (2) | 2024.10.26 |

| Least-Mean-Square Adaptive Filter (LMS) 알아보기 (1) | 2024.10.24 |