목차

수식 전개는 계산 용이성을 위해, complex가 아닌 real을 가정하였습니다.

1. LMS algorithm Overview

Least-mean-square (LMS) 알고리즘은 stochastic gradient 알고리즘의 일종으로, tap-weight를 정확히 gradient 방향이 아닌 randomness 더해진 방향으로 이동시키는 방법을 말합니다. LMS 알고리즘은 gradient descent와 달리 expectation 대신 가장 최신 값만을 사용하여 tap-weight를 업데이트합니다.

LMS 알고리즘은 FIR 필터에 input vector가 주어지면 adaptive하게 tap-weight를 조절하여 desired response와 실제 출력 사이의 error를 최소화합니다. 이를 통해 필터는 최적화되며, desired response에 가까운 output을 생성하게 됩니다.

* Canonical model of the complex LMS algorithm

* Application: Adaptive noise cancelling applied to a sinusoidal interference

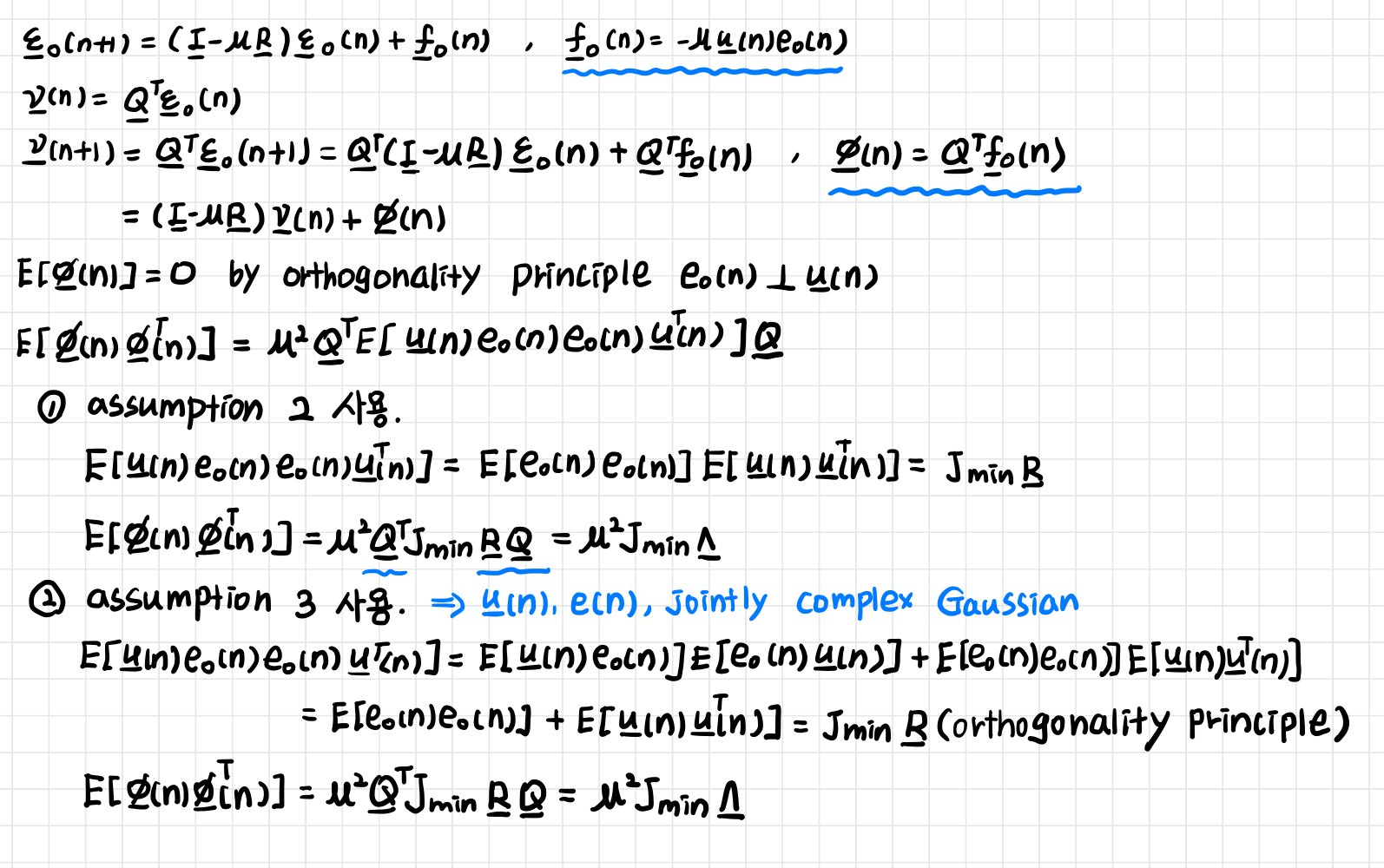

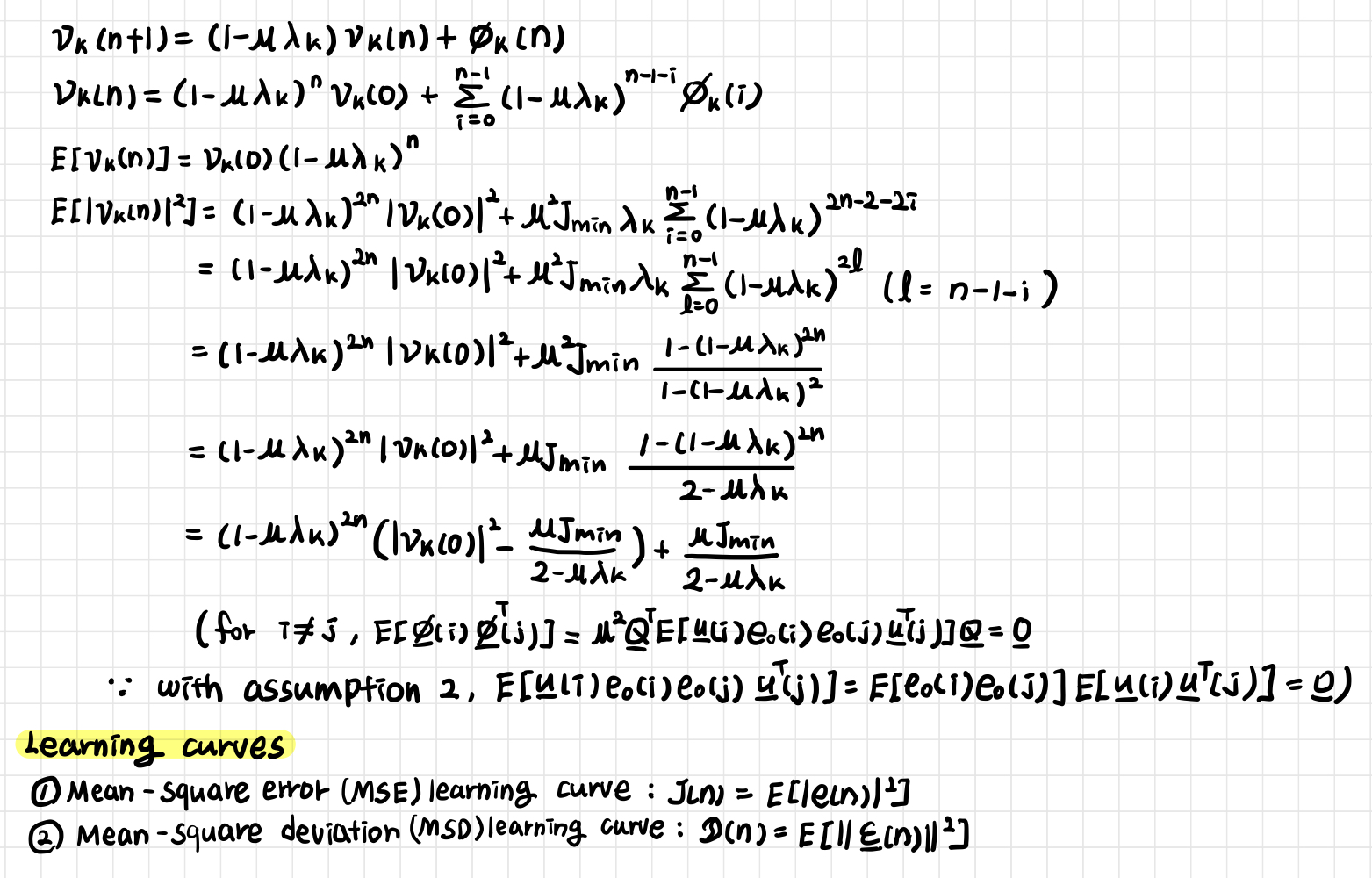

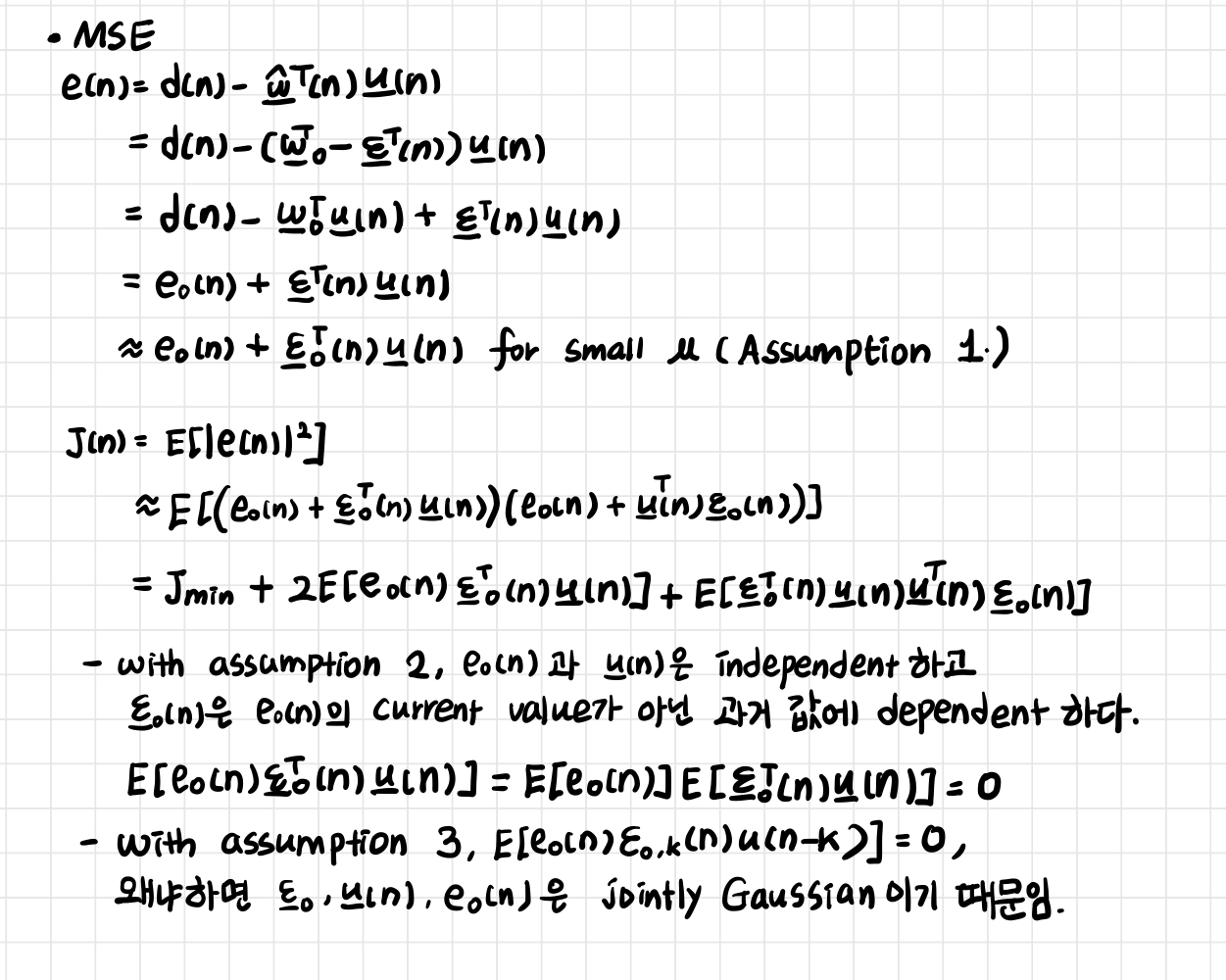

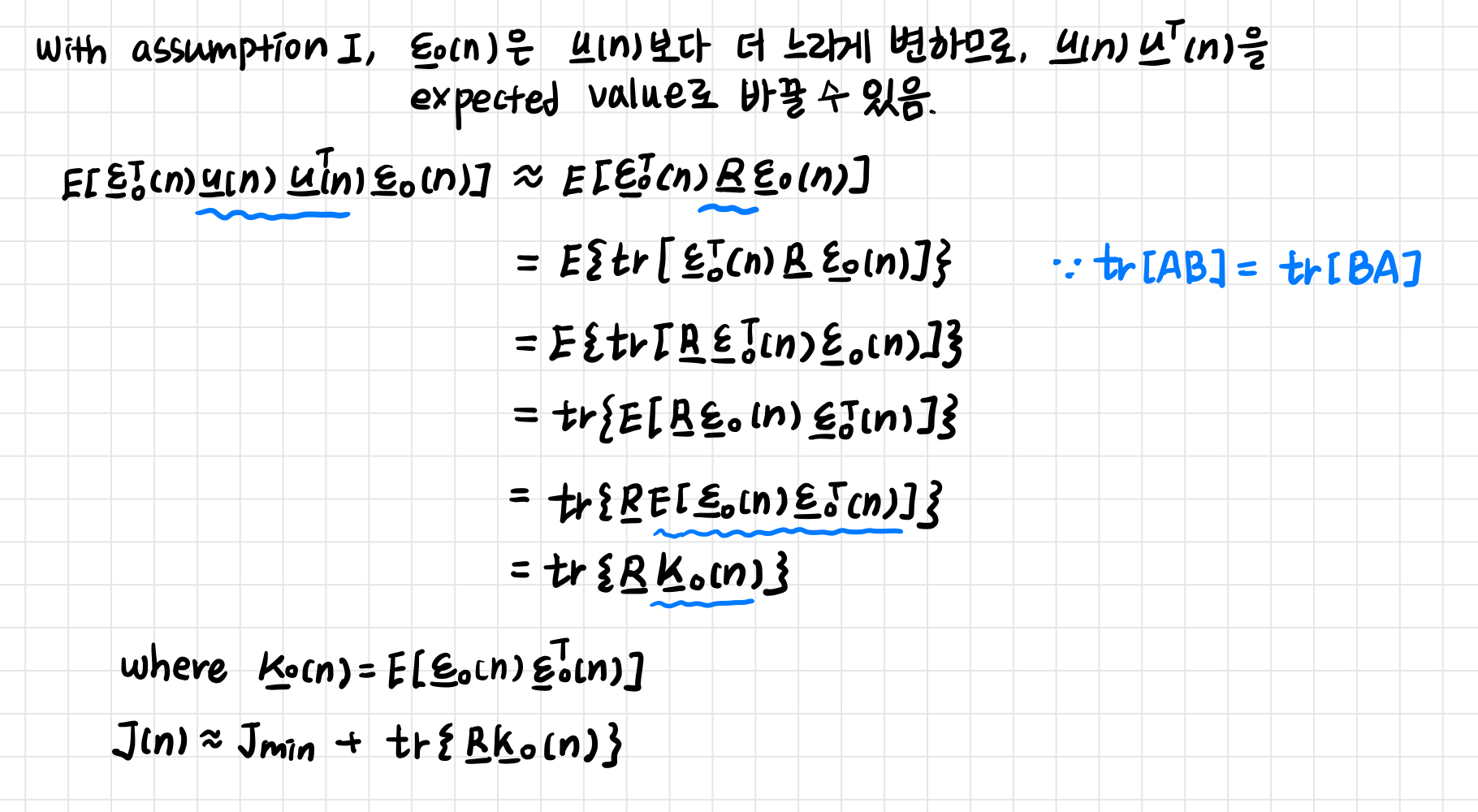

2. Statistical LMS theory

LMS 필터는 linear estimator가 아닙니다. 정확히 linear하게 동작하는 것이 아니라 과거의 입력과 오류를 non-linear하게 결합하여 추정합니다. 이런 특성으로 인해 LMS 필터를 수학적으로 분석하는 건 매우 복잡한 일입니다. LMS 필터는 반복을 통해 tap-weight를 업데이트하면서 weight error vector

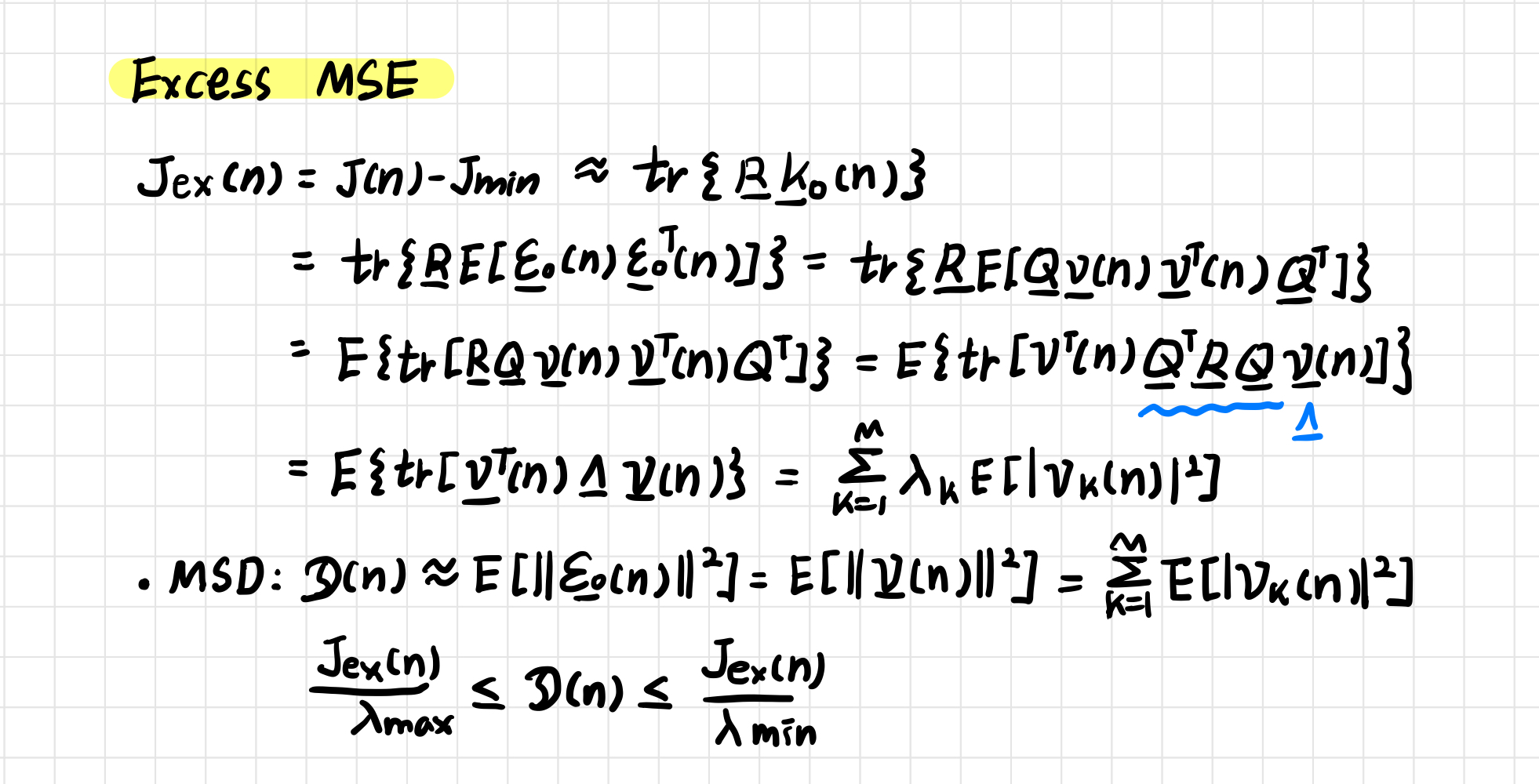

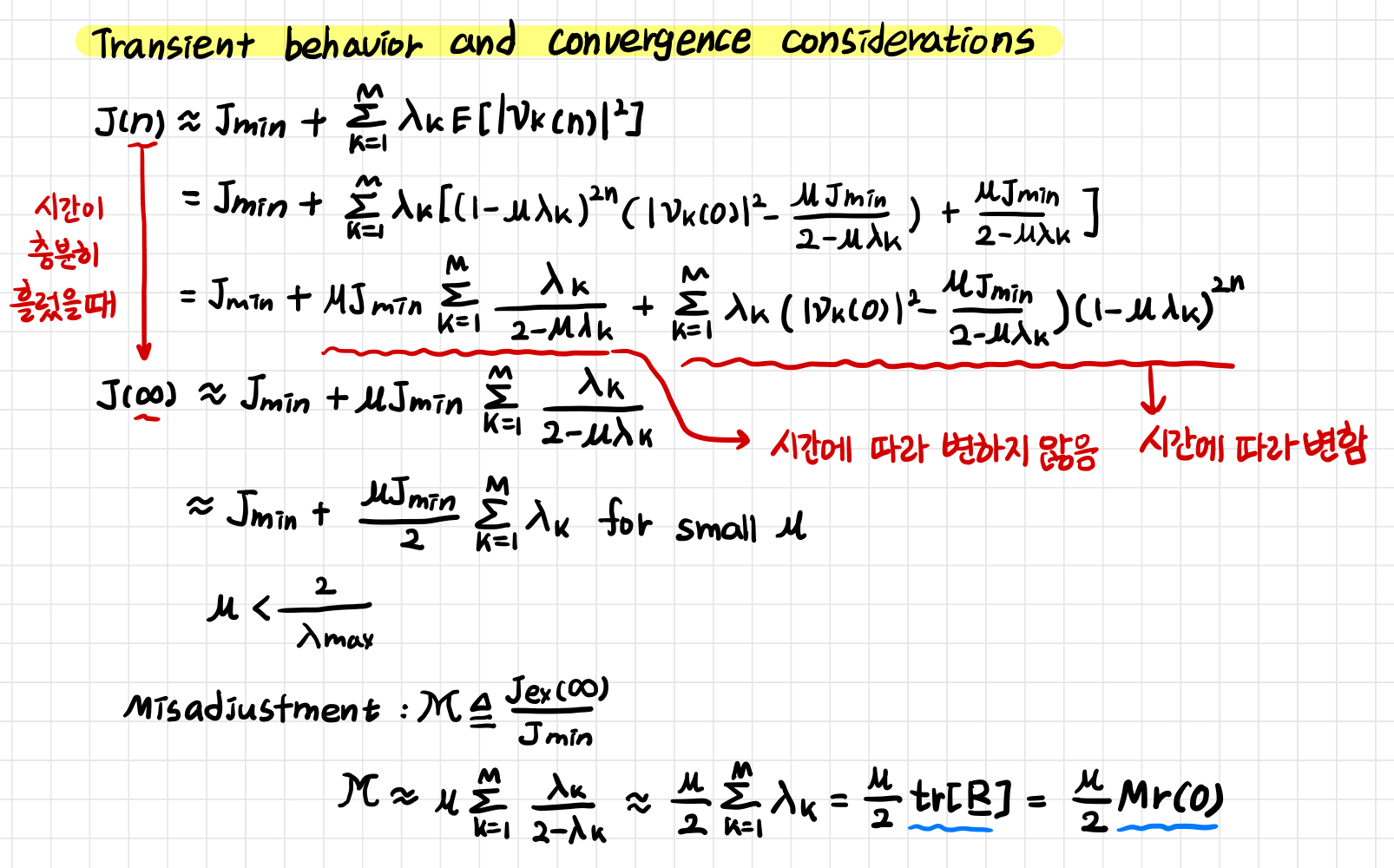

LMS 성능을 분석하기 위해, '1) convergence 2) convergence speed 3) convergence 후 MSE'를 확인하려고 합니다. LMS 필터의 수렴 특성과 MSE를 알려면 3가지 가정이 필요합니다. 첫 번째는,

GIST 신종원 교수님 '적응신호처리' 수업 자료를 바탕으로 쓴 글입니다.

'연구 노트 > 적응신호처리' 카테고리의 다른 글

| Frequency-Domain & Subband Adaptive filter 정리 (1) | 2024.10.28 |

|---|---|

| Fast block LMS 알고리즘 이해하기 (2) | 2024.10.26 |

| Gradient Descent를 위한 최적화 알고리즘 (0) | 2024.10.23 |

| Steepest descent Method 총정리 (0) | 2024.10.22 |

| Linear Prediction 바로 알기 (0) | 2024.10.21 |