목차

2. MMSE criterion을 만족하는 최적의 FIR filter

수식 전개는 계산 용이성을 위해, complex가 아닌 real을 가정하였습니다.

1. Wiener filter

MMSE (minimum mean square error) 최소화하도록 설계된 최적의 linear discrete-time filter를 wiener 필터라고 합니다. 다시 말해, 필터 출력

Wiener 필터 설계 시, FIR로 구현할 것인지 아니면 IIR로 구현할 것인지 고민이 필요합니다. FIR 필터는 IIR에 비해 더 많은 계수를 요구하지만, 안정성이 높다는 장점이 있습니다. 필터 계수가 시간에 따라 변하는 상황에서는 안정성이 중요한데, 이때 FIR 필터가 적합합니다.

추정 오차를 최소화하기 위해 쓰는 대표적인 statistical criterion으로는 MSE (mean-square error)와 MAE (mean absolute error)가 있습니다. MSE는 제곱을 하면 항상 값이 양수가 되고 미분도 비교적 간단하게 수행할 수 있기 때문에 경사하강법(gradient descent)과 같은 알고리즘 에서 많이 쓰입니다.

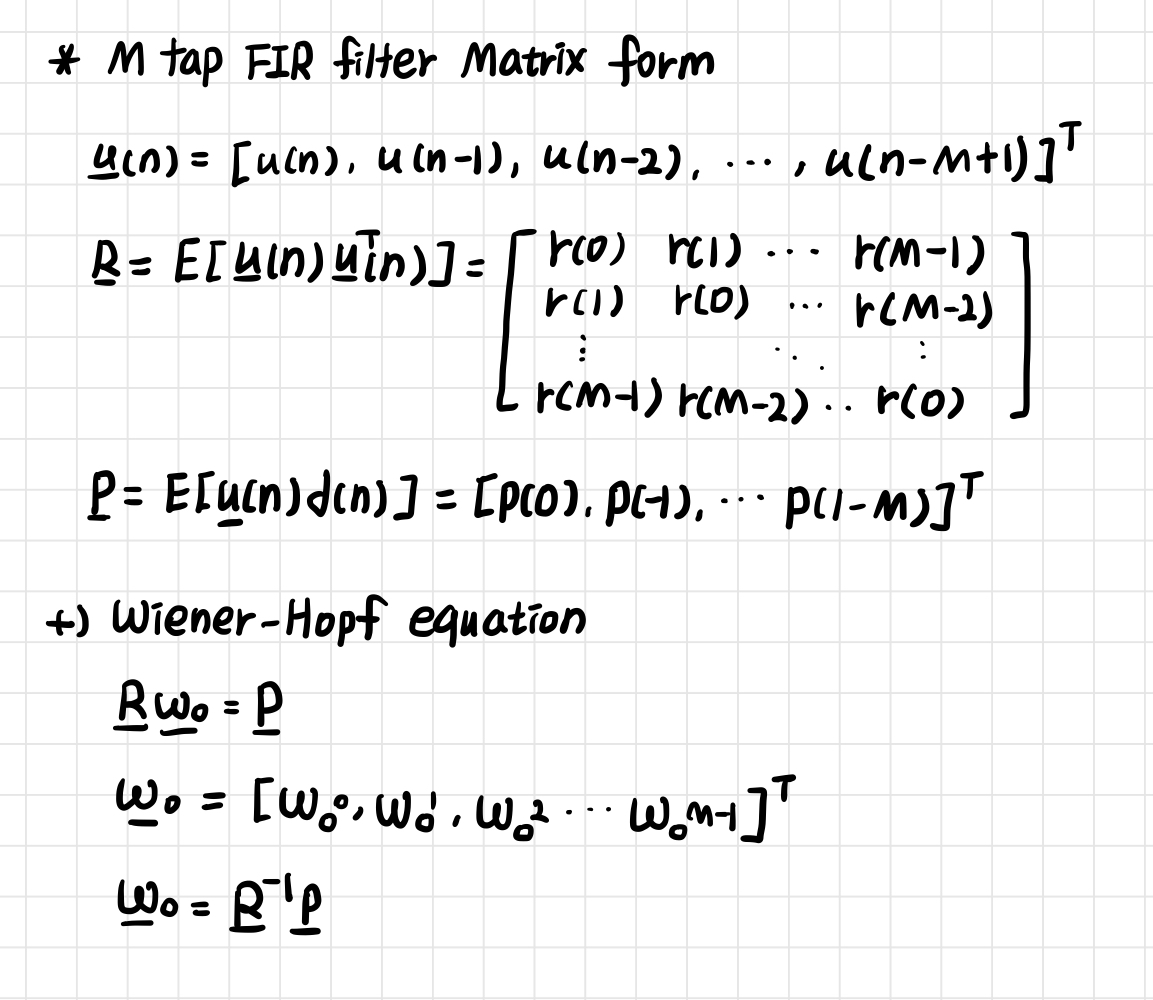

2. MMSE criterion을 만족하는 최적의 FIR filter

MMSE criterion을 따른다고 했을 때, 목표는

3. Orthogonality principle

MMSE 최적화 문제에서 추정 오차

MMSE criterion에서는 cost function을 최소화하는 것이 목표이기 때문에, 그 미분값은 0이 되어야 합니다.

따라서, cost function

Wiener 필터의 optimal한 출력

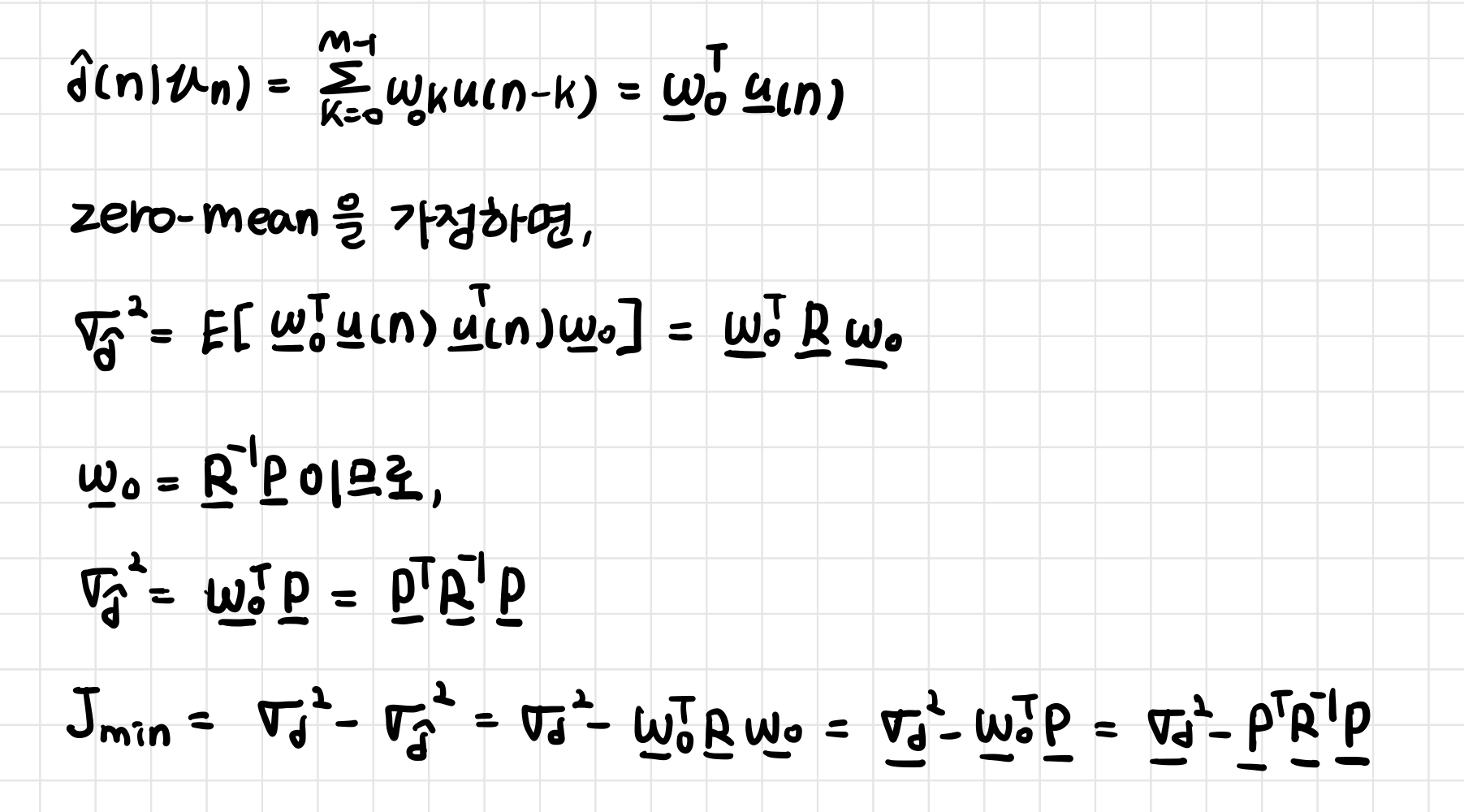

4. Minimum mean-square error

여기서

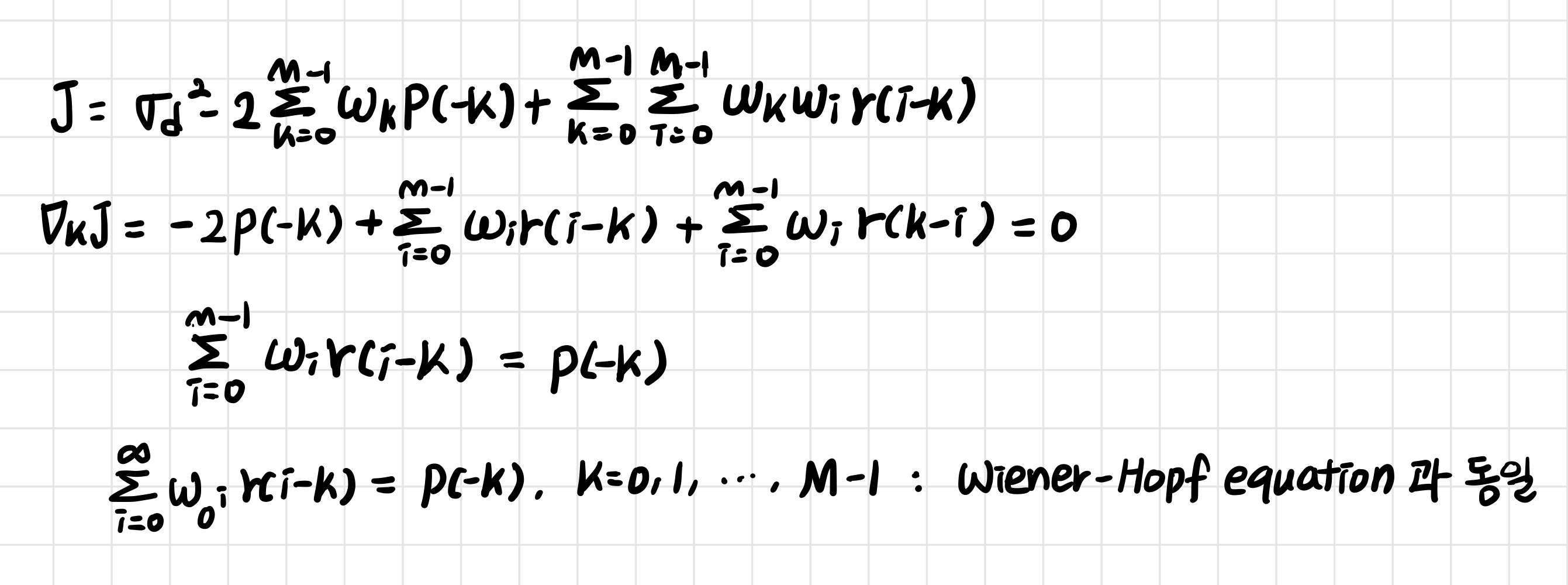

5. Wiener-Hopf equation

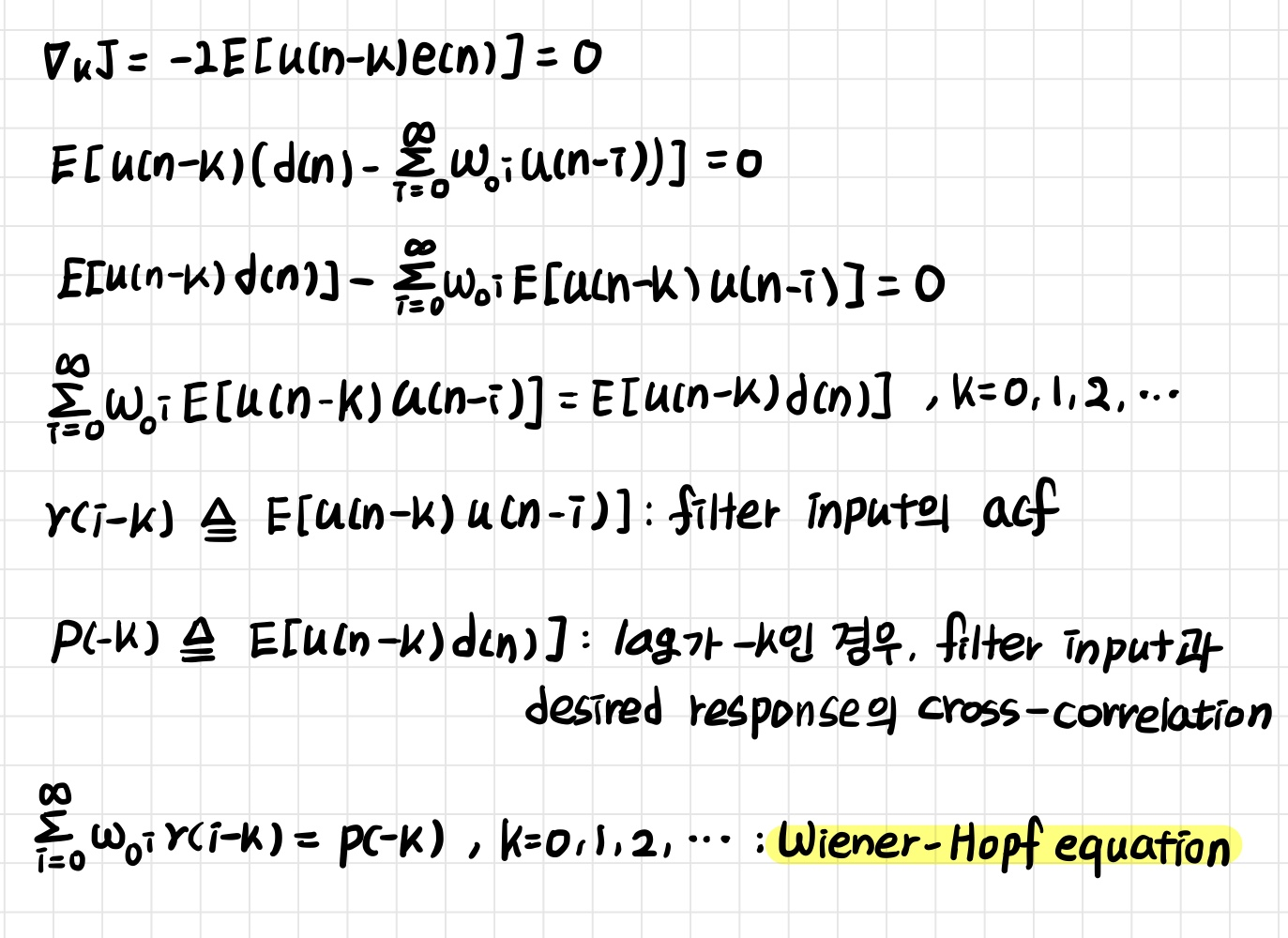

orthogonal principle 식에서

위 그림에서는

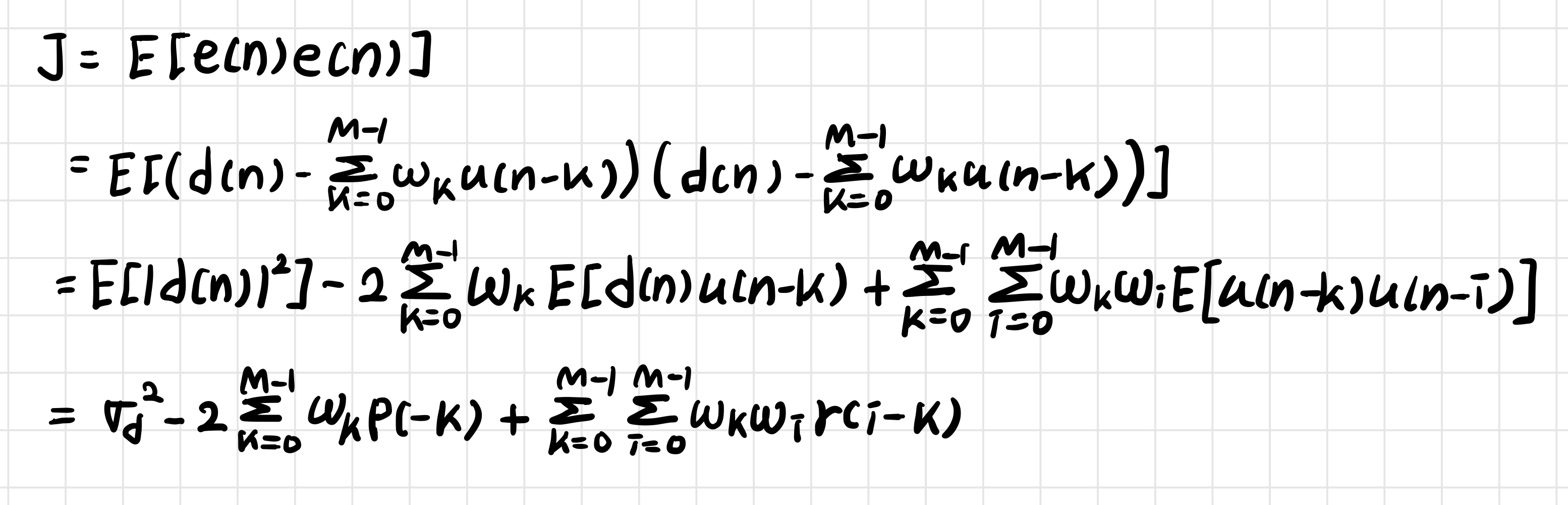

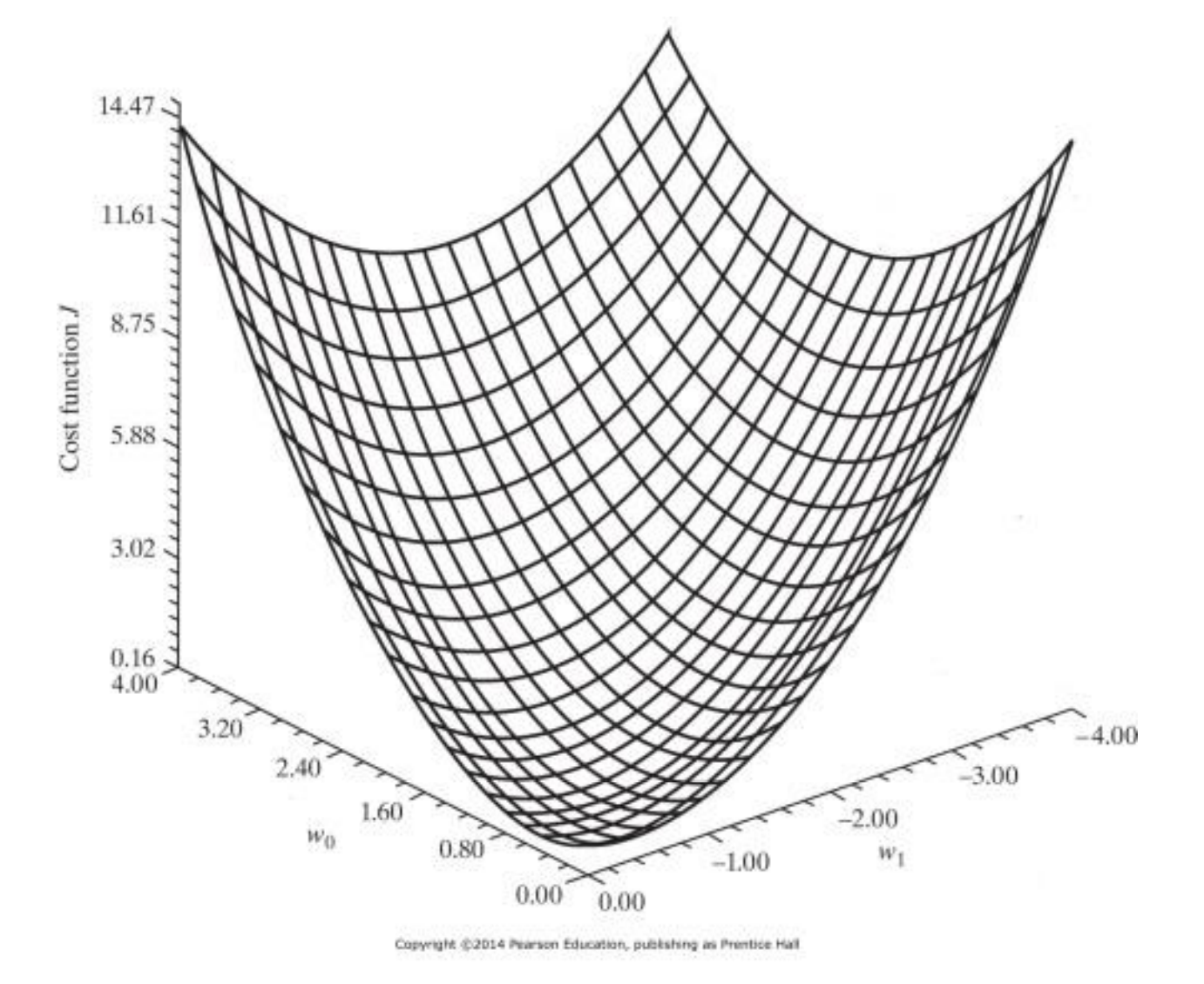

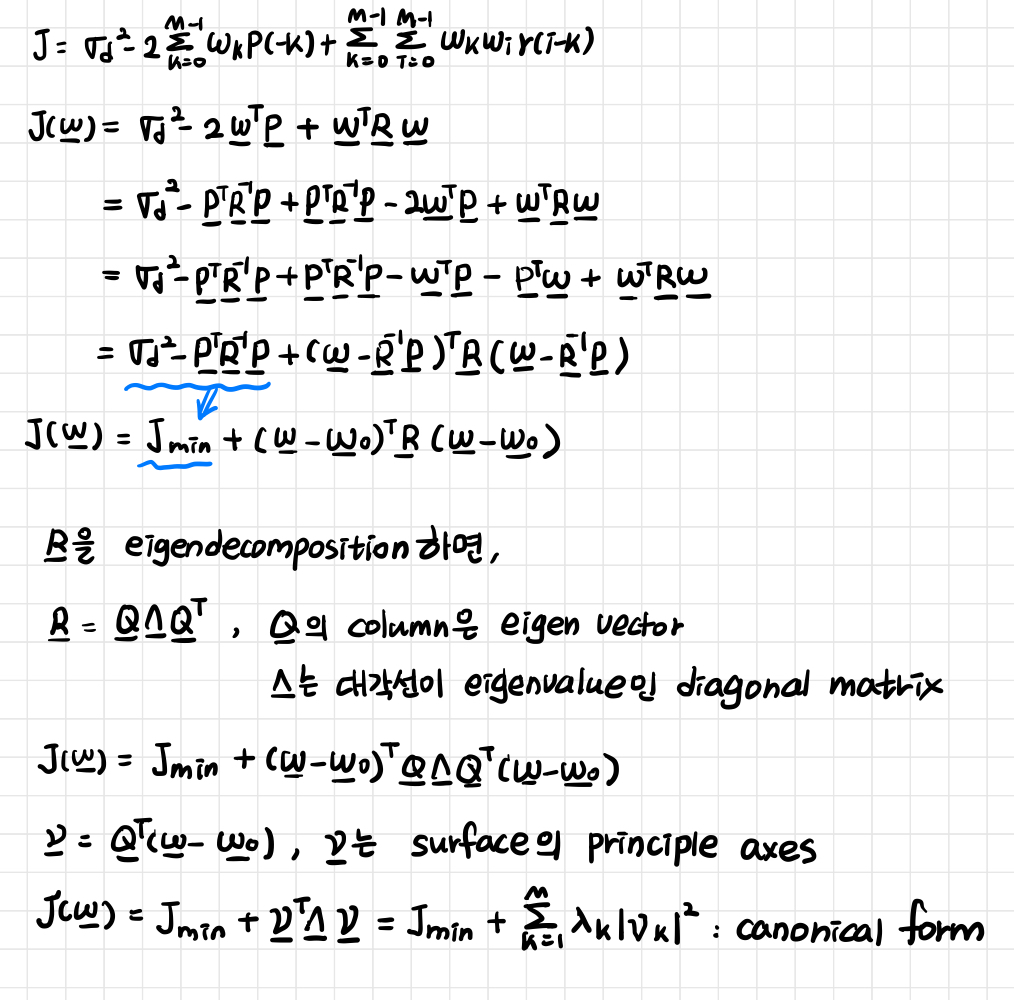

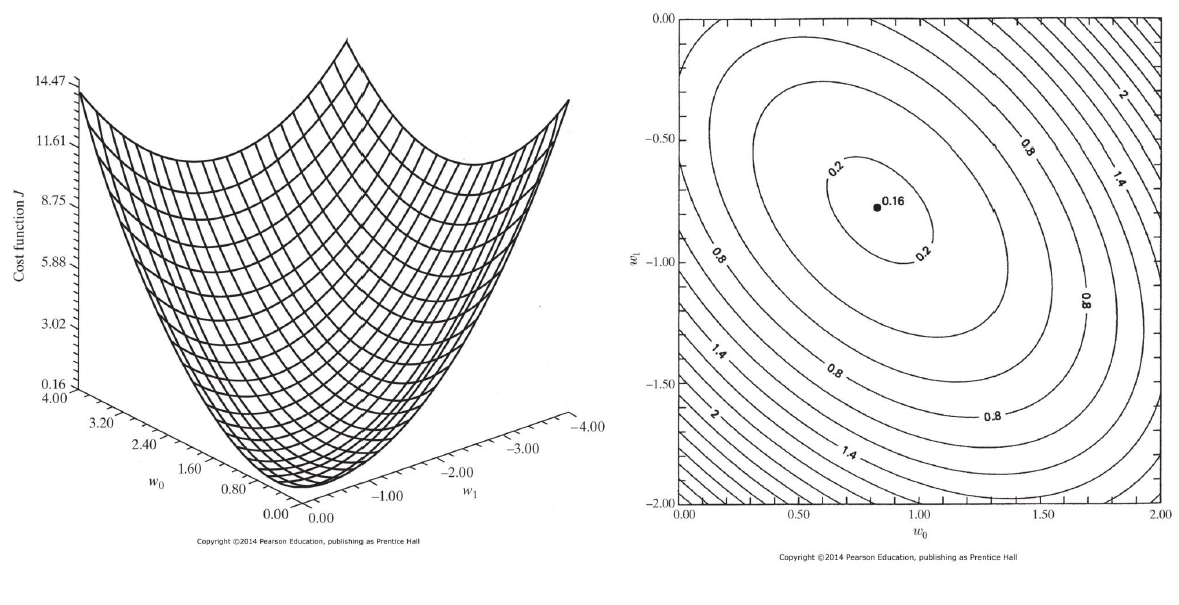

6. Error-performance surface

* cost function

* Minimum MSE

* Error-performance surface의 canonical form

일반적으로 error-performance surface의 최저점이 optimal point가 됩니다. 이 값은 eigen decomposition을 이용해 현재 값에 상관 없이 한 번에 최적값을 구하거나 gradient descent를 이용해 현재값을 가지고 차근차근 최적값을 찾아가는 방식으로 구할 수 있습니다.

GIST 신종원 교수님 '적응신호처리' 수업 자료를 바탕으로 쓴 글입니다.

'연구 노트 > 적응신호처리' 카테고리의 다른 글

| Steepest descent Method 총정리 (0) | 2024.10.22 |

|---|---|

| Linear Prediction 바로 알기 (0) | 2024.10.21 |

| NLMS filter의 Stability (0) | 2024.10.18 |

| NLMS filter 수식 유도 (0) | 2024.10.17 |

| 통계적 신호 처리 Overview (1) | 2024.09.05 |