통계적 신호 처리란 무엇인지 알아보고 estimation, detection의 정의와 classical, bayesian 접근법에 대해 정리해봅시다.

Statistical signal processing

통계적 신호 처리는 검출 및 추정과 시계열 분석을 다루는 디지털 신호처리의 한 분야로, noise를 포함한 관측값을 사용하여 실제로 관찰할 수 없는 미지의 상태 또는 매개변수 최적값을 추정하는 걸 목표로 합니다. 이중에서, 신호 검출 및 추정 (Signal Detection and Estimation)은 신호를 처리하여 유의미한 정보를 추출하는 것을 목적으로 합니다.

Statistics vs Machine learning

통계학과 머신러닝 모두 '데이터로부터 어떻게 학습할 것인가?' 란 질문에서 시작합니다. 통계학에서는 가설 검정, 추정, 신뢰 구간 등 통계적 추론 방법을 사용하여 데이터를 분석하고 결론을 도출합니다. 반면에, 머신러닝에서는 주로 많은 변수를 가지고 있는 고차원 데이터의 패턴을 학습하여 예측 문제를 해결합니다.

Estimation / Detection

- 추정 (Estimation): 연속적인 가설 집합을 가짐 → 특정 매개변수나 값을 연속적인 범위로 가정함, 실제로 정확한 값을 찾기 어렵기 때문에 실제 값과의 오차를 최소화하는 것을 목표로 함

- Ex) Radar (항공기 위치 추정), Sonar (잠수함 위치 추정), Speech recognition (음소 추정), image analysis (물체 위치/방향 추정), biomedicine (심박수 추정), Communication (전송된 신호에서 원래 정보를 추출할 수 있도록 carrier frequency 추정)

- 검출 (Detection): 이산적인 가설 집합을 가짐 → 가능한 가설이 명확히 구분된 이산적인 값으로 이루어짐, 보통 가설이 맞거나 틀리는 경우로 나뉨

- Ex) Radar (항공기 존재 유무 검출), Digital communication (0 또는 1이 전송됐는지 검출), Speech recognition (발음한 숫자 인식), Sonar (잠수함 존재 유무 검출), Image processing (적외선으로 항공기 존재 유무 검출), Biomedicine (부정맥 여부 검출), Seismology (지하 유전 존재 유무 검출)

Classical / Bayesian

- Classical: 가설/매개변수가 fixed, non-random

- Bayesian: 가설/매개변수를 확률 변수로 취급하며 사전 확률 분포를 가정함 (random value, random variable, random parameter)

- 가설 (Hypothesis): 주어진 입력 데이터에 대해 어떤 출력을 예측하는 함수

- 매개변수 (Parameter): 가설 함수 내부의 조정가능한 요소 (ex. weight, bias)

Mathematical estimation problem

데이터가 random한 특성을 가지고 있어서 정확히 예측할 수 없는 경우, 특정 값이 나올 확률을

관측값

Estimation type

- Classical estimation

- 파라미터가 고정 (fixed, deterministic)되어 있다고 가정함

- Bayesian estimation

- 파라미터를 확률 변수로 가정하기 때문에 prior knowledge를 활용한 유연한 추정이 가능

- 데이터를 나타내는 joint PDF는 prior knowledge

p(θ) p(x|θ)

- Estimator: 확률 변수를 입력으로 받아 파라미터 x 를 추정하는 함수 또는 규칙 (RV → RV) θ

- Estimate: 특정 데이터로부터 얻은 추정값ˆθ ˆθ=g(x)

-: estimator g

-: estimate ˆθ

-: particular value x

Accessing estimator performance

estimator의 성능을 어떻게 평가할 수 있는지 살펴보겠습니다. 먼저, noise에 DC 성분이 포함되어 있다고 가정해봅시다. (일반적인 sound signal은 평균값이 0인 AC 성분만 가지는데 DC 성분이 추가되면 평균 값이 0이 아닌 상태가 됨)

candidate estimator로 샘플 평균값과 첫 번째 샘플을 쓴다고 했을 때, 각 estimaor의 mean과 variance를 구함으로써 어떤 것이 더 쓰기 좋은지 알 수 있습니다.

아래 그래프를 살펴보시면, 한 샘플의 값만 사용하는 것보다 샘플 여러 개의 평균값을 사용하는 게 상대적으로 변동성이 작은 걸 확인할 수 있습니다.

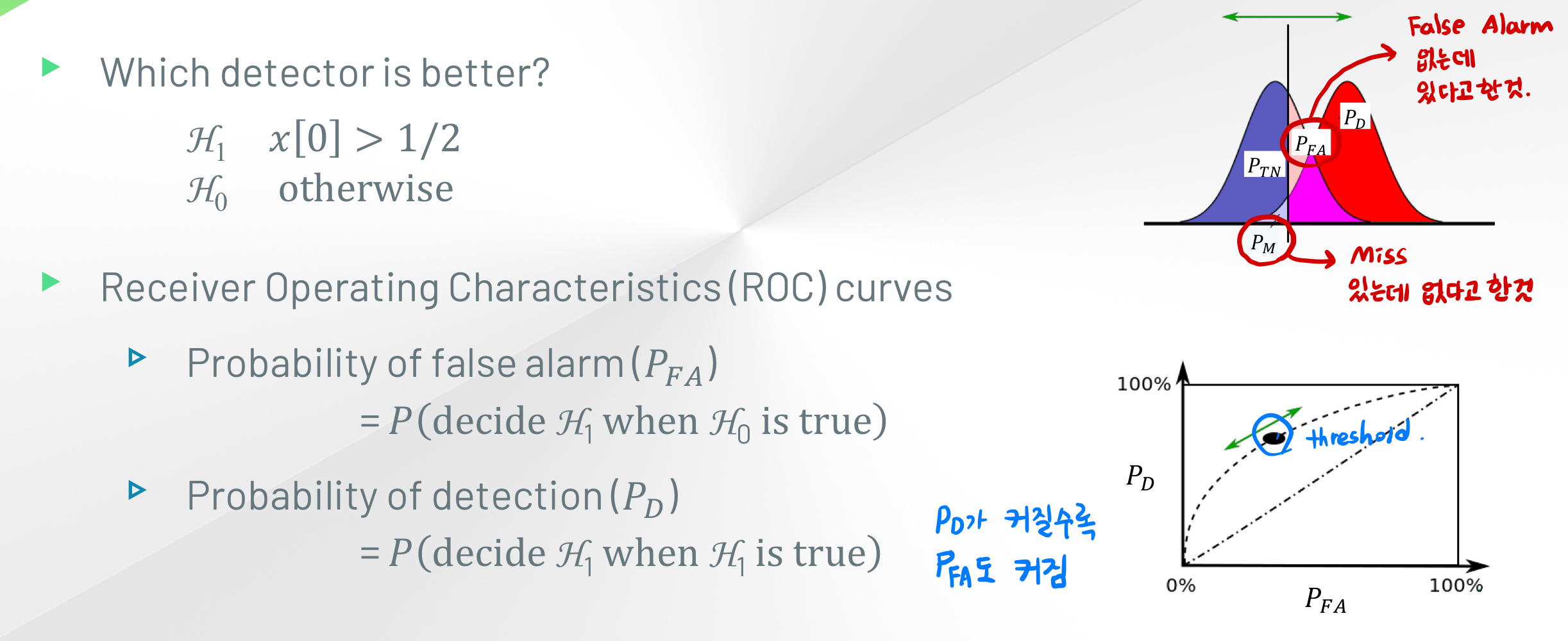

이번에는 이진 가설 검정 (binary hypothesis test) 예시를 살펴보겠습니다. signal이 없고 noise만 존재하는 경우를 귀무가설로, signal이 존재하는 경우를 대립가설로 두었습니다.

threshold 값이 1/2를 넘으면 signal이 존재하고 넘지 않으면 noise만 있다는 판정을 내릴 때,

PFA PD

이상적인 detector라면

GIST 황의석 교수님 '검출및추정' 수업 자료를 바탕으로 쓴 글입니다.

'연구 노트 > 적응신호처리' 카테고리의 다른 글

| Linear Prediction 바로 알기 (0) | 2024.10.21 |

|---|---|

| Wiener filter 총정리 (0) | 2024.10.19 |

| NLMS filter의 Stability (0) | 2024.10.18 |

| NLMS filter 수식 유도 (0) | 2024.10.17 |

| Adaptive filter 정의, 사용 이유, 활용 예시 (0) | 2024.09.03 |